最新更新,模型是 Llama 3.1 70B lora 微调,纯粹为了刷榜。实际使用上只是 reflection prompt 设计有点用。

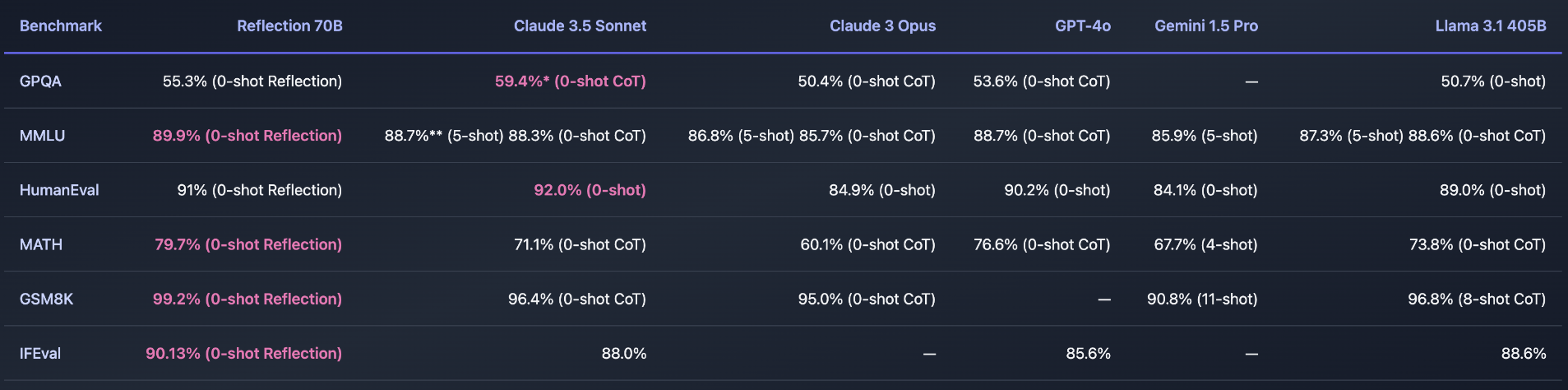

Reflection-Tuning 的新技术让开源大模型(Llama 3.1 70B)在性能上超越了 Claude 3.5 和 GPT-4o。这项技术通过在 结构化合成数据 上训练模型,帮助模型检测推理错误,并自行修正错误,显著提升了推理能力。下面是评测指标。感觉大模型训练不仅可以走合成数据路线也可以走强化学习的路子,就像这里Reflection

技术工作原理:

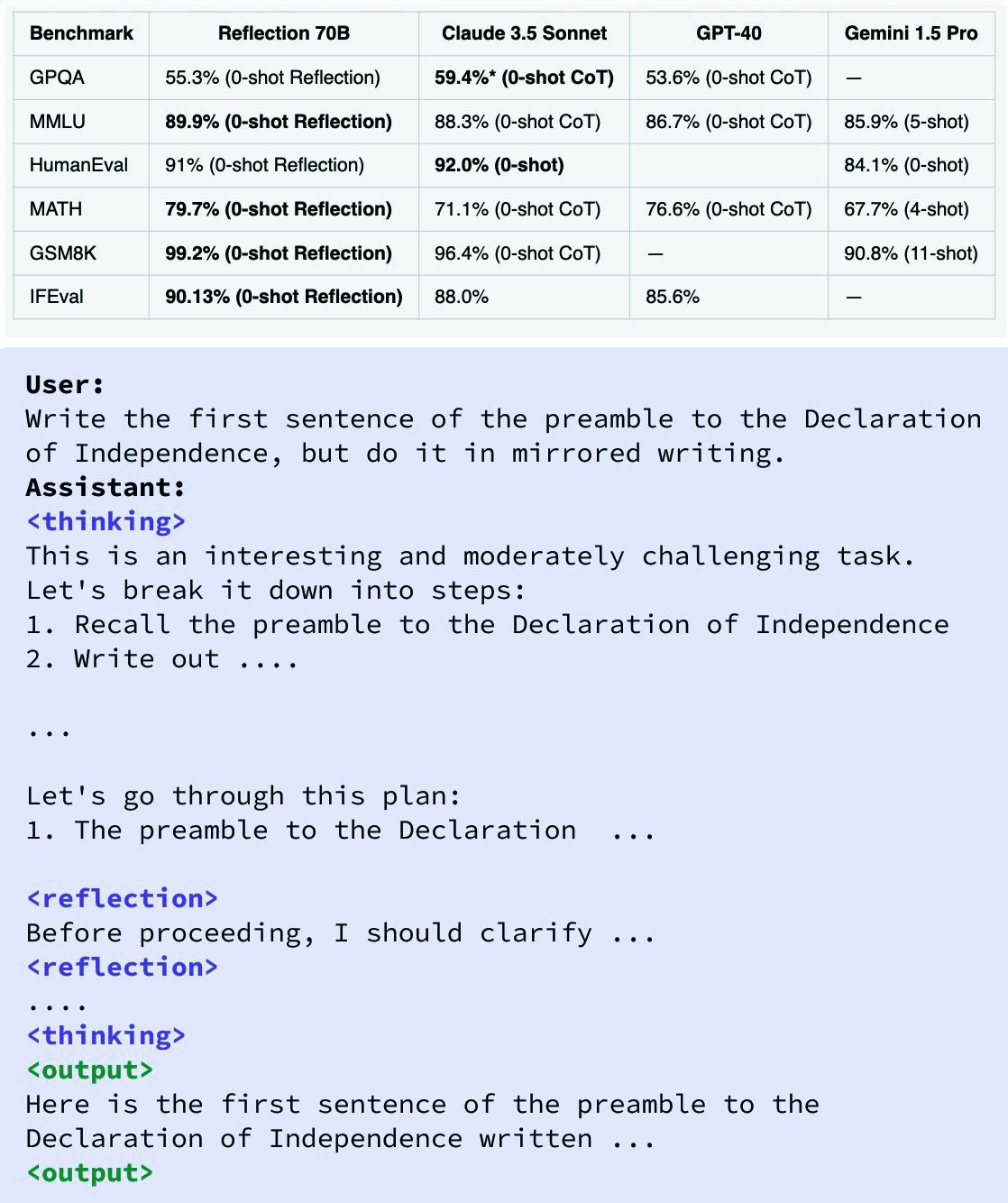

- 推理阶段:在推理过程中,模型会在

<thinking>标签中生成推理过程的相关内容。 - 错误检测与修正:当模型检测到推理中的错误时,会使用

<reflection>标签进行自我修正。 - 最终答案:模型在完成自我纠正后,才会通过

<output>标签生成最终答案。

实验结果:

- 性能表现:该技术在多个基准测试中表现优异:

- MMLU 基准测试中得分 89.9%

- MATH 测试中得分 79.7%

- IFEval 测试中得分 90.1%

这些成绩均超越了 GPT-4o。

- 训练过程:此技术基于 Llama 3.1 70B Instruct 模型,增加了特殊的标记以增强模型的推理能力。

- 去重验证:使用 LMSys’s LLM Decontaminator 检查基准测试,确保模型未使用重复或泄露数据。

总结:

Reflection-Tuning 技术通过让模型在推理中发现并纠正自身错误,显著提升了模型的推理能力和答案准确性。这一突破意味着开源模型在复杂推理任务中也能展现出媲美甚至超越封闭模型的实力。

这项技术将推动开源大模型在更多应用场景中的广泛使用,引领智能推理领域的新方向。

正文完

发表至: 每日技术

2024-09-07